GoogleNet(Going deeper with convolutions)

1. Introduction

연산을 하는데 소모되는 자원의 사용 효율 개선 -> 네트워크의 depth와 width를 늘려도 연산량이 증가되지 않고 유지됨을 의미

GoogLeNet의 코드네임인 Inception이란 이름은 Network in Network(NIN)라는 논문에서 유래하였으며, 인셉션 영화의 대사인 "we need to go deeper"에서 착안하였다. 이때 "deep"은 두 가지 의미를 가진다.

1. "Inception module"의 형태로 새로운 차원의 구조 도입

2. 두 번째는 네트워크의 깊이가 증가하였다는 직접적인 의미

2. Related Works

network-in-network 방법이란? 1x1 conv layer와 ReLU를 사용하는 것

- 차원감소로 인한 병목현상 제거

3. Motivation and High Level Considerations

심층 신경망의 성능 개선 == network의 사이즈 증가(=깊이, 너비 증가)

Google 팀의 Inception 구조는 위에서 말한 유사 Sparse 구조를 시험하기 위해 시작되었다.

그리고 러닝 레이트와 하이퍼 파라미터를 조정하고 훈련 방법 등을 개선한 결과, Localization 및 Object detection 분야에서 특히 좋은 성능을 보였다고 한다.

4. Architectural Details

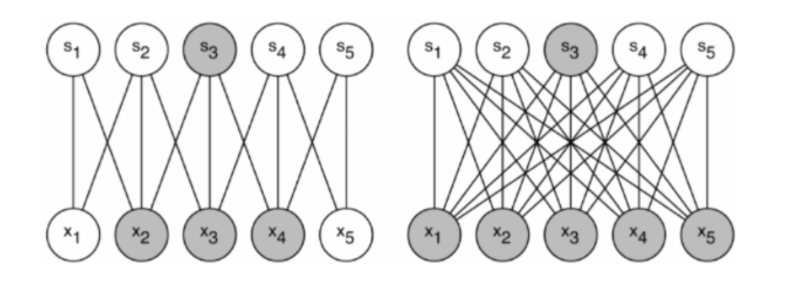

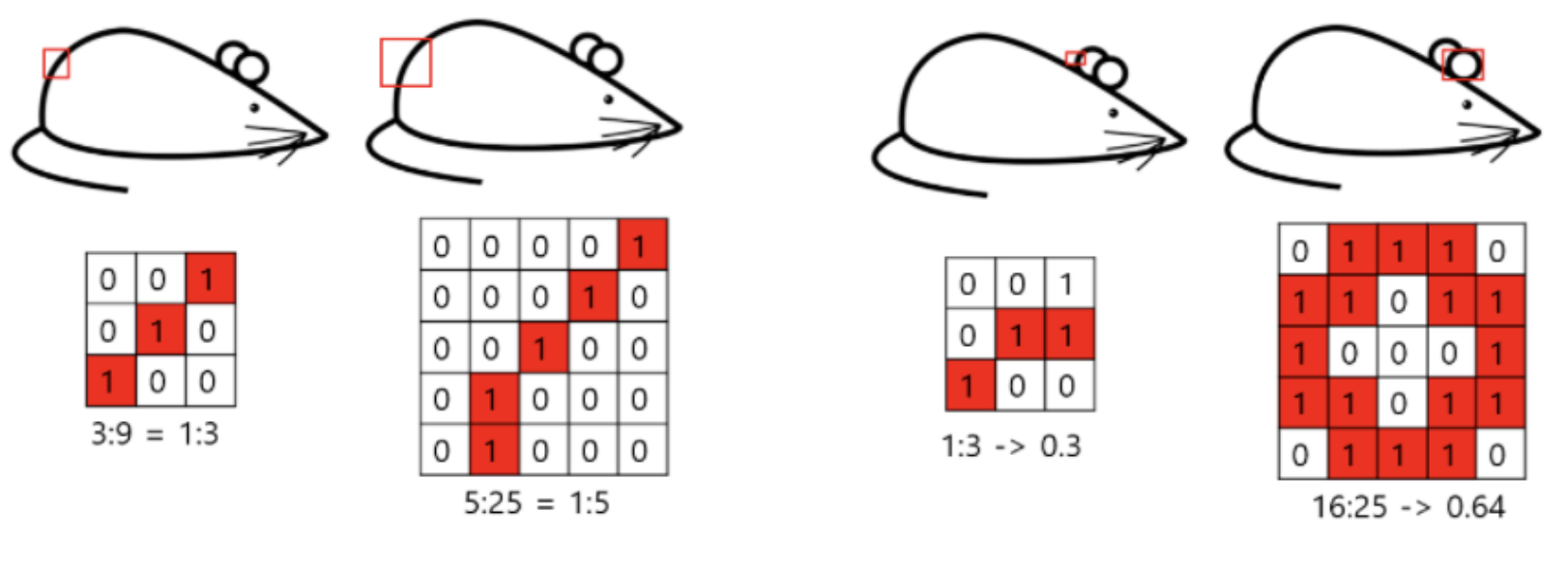

핵심 아이디어: Sparse 매트릭스를 서로 묶어 상대적으로 Dense 한 Submatrix를 만든다는 것

(b) : (a) 방식에 1x1 필터를 두어 차원을 줄이고, 여러 scale을 확보하면서도 연산량을 낮출 수 있게 됨

- 1x1 필터 기능 : 차원 축소, ReLU

즉, 네트워크 크기를 늘리면 오버피팅과 계산량 증가 문제->네트워크를 sparse하게 구성 -> 그러나 sparse한 구조는 하드웨어 계산에서 비효율적이므로 이러한 sparse들을 클러스터링하여 상대적으로 dense하게 만드는 것!

- ReLu를 통해 비선형성 추가

- 1. 과도한 연산량 문제없이 네트워크 크기 증가-> 차원 축소를 통해 다음 layer의 input을 조절할 수 있기 때문

- 2. 시각 정보가 다양한 규모로 처리되고 다음 layer는 동시에 서로 다른 규모에서 특징을 추출할 수 있게 된다. 1x1, 3x3, 5x5 convolution 연산을 통해 다양한 특징을 추출할 수 있기 때문

5. GoogleNet

Input : 224 224 3

#3x3, #5x5는 1x1 필터가 사용된 후 바로 연결

Part1

낮은 레이어가 위치해있는 부분

Part2

Inception module

part2에서는 다양한 특징을 추출하기 위해 1 x 1, 3 x 3, 5 x 5 Convolutional layer가 병렬적으로 연산을 수행하고 있으며,

차원을 축소하여 연산량을 줄이기 위해 1 x 1 Convolutional layer가 적용되어 있는 것을 확인할 수 있다.

Part3 : auxiliary classifier

모델의 깊이가 매우 깊을 경우, 기울기가 0으로 수렴하는 gradient vanishing 문제가 발생

Part4 : 끝부분

최종 Classifier 이전에 GAP가 적용된 average pooling layer

(FC layer를 classifier로 사용하는 경우 파라미터의 수가 많이 증가하는 단점이 있으며 feature 전체를 matrix 연산하기 때문에 위치에 대한 정보도 사라지게 됩니다. 더구나 FC Layer 사용 시 반드시 지정해 주어야 하는 FC layer의 사이즈로 인해 입력 이미지 사이즈 또한 그에 맞춰서 고정되어야 하는 단점이 존재)

6. 성능

기존 방법과는 다른 새로운 방법

photometric distortions(광도 왜곡)를 통해 학습 데이터를 늘렸다고 한다.

'AI 논문 공부' 카테고리의 다른 글

| R-CNN, Fast R-CNN, Faster R-CNN 논문 리뷰 (1) | 2023.01.27 |

|---|---|

| Deformable Convolutional Network (DCN) 논문 리뷰 (0) | 2023.01.13 |

| resnet 논문 리뷰 (1) | 2023.01.07 |

| vggNet 논문 리뷰 (0) | 2022.11.30 |

| AlexNet 논문 리뷰 (0) | 2022.11.30 |