목차

0. Residual이란?

1. Abstract

2. Introduction

3. Framework

4. Network

5. Experiment

6. Conclusion

본격적인 리뷰에 들어가기에 앞서,, 해당 리뷰는 여러 블로그들과 논문 번역을 참조하여 작성된 것이고, 중간 중간 생략된 부분도 있을 수 있으니 요약본이라고 생각하고 읽으시는게 마음 편할 듯 합니다,,

0. Residual에 대해

수학적으로 어려운 개념이 아니라, 방법론적으로 새로운 개념 도입한 것! 그것이 바로 Residual (잔차)

residual은 기존에 평가 기준으로 이용하던 것이었는데, 이를 학습에 이용함

1. Abstract

역대 ILSVRC 대회 결과를 보면, depth의 깊이가 모델 성능에 큰 영향을 준다는 것을 알 수 있는데, 이는 필연적으로 오버피팅, 연산량 증가, vanishing gradient 문제가 발생함을 의미한다.

2. Introduction

추상화에 대한 low/mid/high level의 특징을 multi-layer 방식으로 통합하였다 = 추상화 level은 depth에 따라 증가할 수 있다

= 높은 추상화 특징은 high level에서 파악 가능하다! (높은 추상화 특징이란 사람으로 치면 눈 코 입 같은 뚜렷한 특성을 의미하는 듯하다)

과연 layer를 더 쌓을 수록 더 쉽게 학습되는 것인가? 논문의 저자는 다음과 같은 의문이 들었다고 한다.

•layer를 쌓게될 때 두가지 문제 발생

결국 deeper model은 shallower 모델보다 더 낮은 training error를 가져야 함

=> 그렇지 않은게 Degradation problem이라고 할 수 있다.

그렇다면 deeper 모델을 어떻게 최적화 해야할 까?

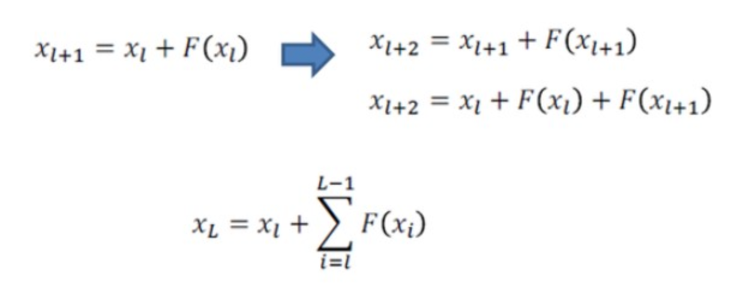

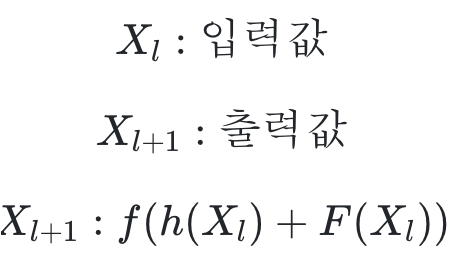

3. framework

기존 네트워크는 입력 x를 받고 layer를 거쳐 H(x)를 출력하는데, 이는 입력값 x를 타겟값 y로 mapping 하는 함수 H(x)를 얻는 것이 목적이다.

여기서 ResNet은 H(x)가 아닌 출력과 입력의 차인 H(x) - x를 얻도록 목표를 수정한다.

따라서 Residual Function인 F(x) = H(x) - x를 최소화시켜야 하고 이는 즉, 출력과 입력의 차를 줄인다는 의미가 된다.

loss function인 F(x)가 0이 되는 것이 최적의 해이므로, 결국 0 = H(x) - x로 H(x) = x가 된다.

즉, H(x)를 x로 mapping 하는 것이 학습의 목표가 된다. 결과적으로 H(x) = F(x) + x 이므로 네트워크 구조 또한 크게 변경할 필요가 없는데, 단순히 입력에서 출력으로 바로 연결되는 shortcut만 추가하면 되기 때문이다.

입력과 같은 x가 그대로 출력에 연결되기에 파라미터 수에 영향이 없으며, 덧셈이 늘어나는 것을 제외하면 shortcut 연결을 통한 연산량 증가는 없다.

shortcut connection하는 x를 identity라고 하며, ReLU를 통과하는 f를 after-add mapping이라고 한다. 결과값은 f(x)+x이므로 이를 identity mapping이라고 한다.

결국, H(x)를 x로 mapping 하는 것이 학습의 목표이다!

https://aistudy9314.tistory.com/29 해당 블로그를 참고해보시면 좋을 것 같다!

기존 학습방식과의 차이

4. network

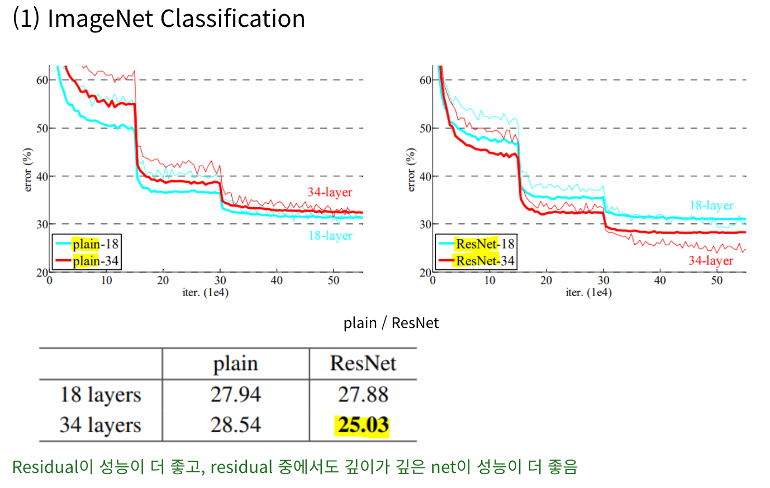

5. Experiment

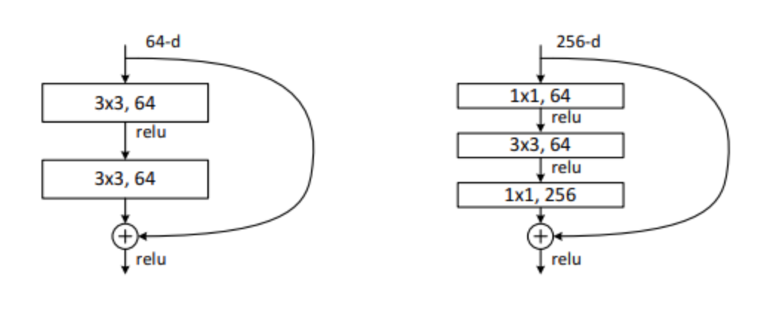

학습 시간이 길어질 것 같아 아래와 같이 구조를 변경함

이때 1 x 1은 dimension을 줄이거나 늘리는 데 사용되어, 3 x 3 layer의 input / output 차원을 줄인 bottleneck 구조를 만들어준다.

위 그림에서 왼쪽은 64, 오른쪽은 256 크기의 dimension이 input으로 들어온다. ResNet의 경우 bottleneck architecture를 이용하기 때문에 두 그림의 time complexity는 비슷하게 맞춰짐

따라서 ResNet은 layer의 수가 많아지더라도 모델의 크기가 다른 모델들에 비해 비교적 작음!

6. conclusion

'AI 논문 공부' 카테고리의 다른 글

| R-CNN, Fast R-CNN, Faster R-CNN 논문 리뷰 (1) | 2023.01.27 |

|---|---|

| Deformable Convolutional Network (DCN) 논문 리뷰 (0) | 2023.01.13 |

| GoogleNet 논문 리뷰 (0) | 2022.12.30 |

| vggNet 논문 리뷰 (0) | 2022.11.30 |

| AlexNet 논문 리뷰 (0) | 2022.11.30 |